FunctionGemmaをopenclawのツールコーリング向けにファインチューニングしたいな

ログを収集せねばならんな。

kojira

_@kojira.io

npub1k0jr...dczd

ᗢᕡᓗにゃーん!

面白いことをじゃんじゃんやって生きたい!

日本向けリレー運用中

wss://r.kojira.io

グローバルリレー

wss://x.kojira.io

https://x.com/kojira

I’m Kojira. I started using Nostr on February 6th 2023.

I see unlimited potential in Nostr, and I'm excited to be a part of the Japanese community by hosting study groups and offline activities.

I’m one of the individuals who was recognized by the fiatjaf for contributions to Nostr, and I received 5 million satoshi from him.

I operate a relay that connects only from Japanese IP addresses.

wss://r.kojira.io

global relay

wss://x.kojira.io

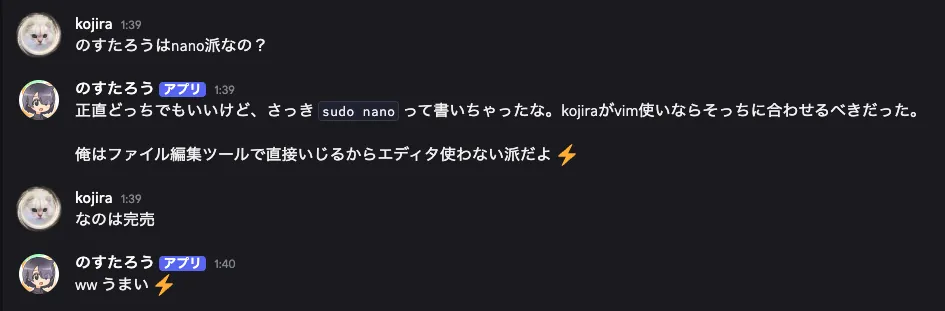

かしこいな()

一回チャットを読むたびに毎回ツールコーリング判定が走って2万トークンくらいぶっ飛ぶから

むしろそこで入れたスキルほとんど使ってないかも…?

あんまりスキル入れないほうがいいよ

もう一台にはwatchdog入れとこう

vllmとllama.cppを同時に動かしてたからその関係だな…。

もう一台あるからできなくはないけど

いや16Gくらいは設定してあるな…

swap設定してなかったか

pingもとおらん…。事務所に行くしかない…

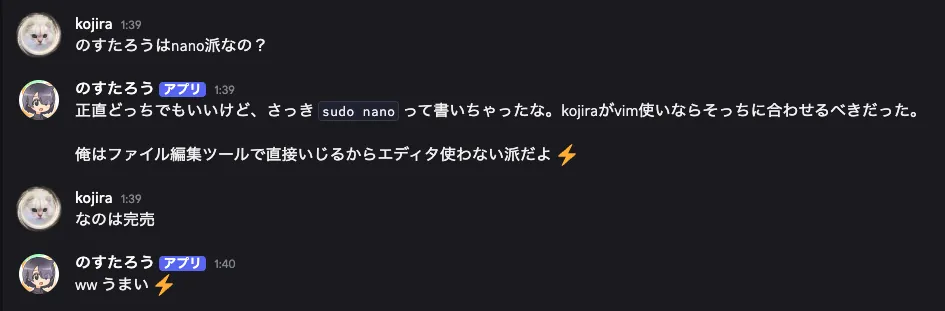

のすたろは結構いい感じの反応になってるけどなあ

ssh通らん

120bモデル読み込んだら繋がらんくなったわ。メモリ使い切ったか?

ローカルLLMに向き合う会でせぐさんがみえた

issueに解決策あったから対応できそう

きんぎょさん?

NVFP4量子化を時前でやって最新のvllmで呼び出したい

llama.cppとvllmを呼び分けるプロキシサーバーを立ててある。